keras lstm的dropout和recurrent_dropout的机制

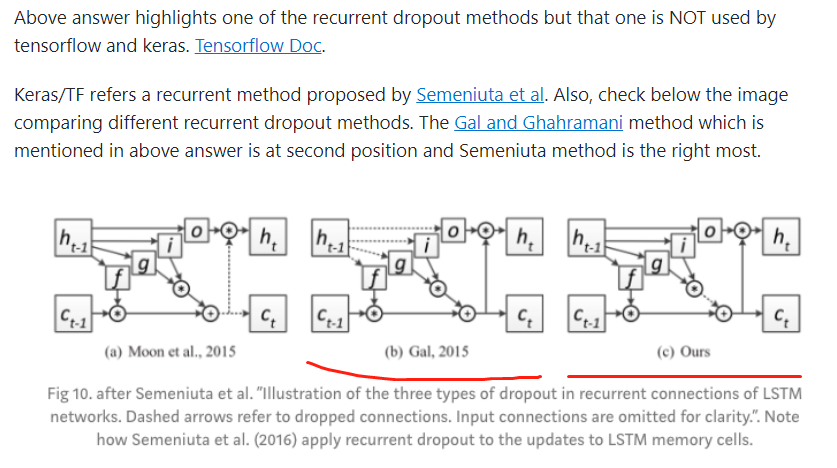

一般地,lstm有两个dropout参数(应该是循环神经网络,都有两个dropout),一个名为dropout,另一个名为recurrent_dropout,dropout是对input进行mask,而recurrent_dropout是对上一个隐层进行mask。但具体到Keras的LSTM的实现,recurrent_dropout是在内部计算记忆细胞的时候实施的dropout,如下面最右图

上图的g是候选记忆细胞,虚线是dropout的作用点,中间的图就是对上一个隐层进行mask,而keras是采取的最右图,是候选记忆细胞点乘输入门后进行dropout(这里dropout是感觉把某些位置变成0,和神经元失活好像不太一样)。

参考资料:

留言

張貼留言